Tianhe-2, still the most powerful computer of the world

According to the well known top500.org, the list of the most powerful supercomputers in the world, the supercomputing speedup is suffering an slow down. Today November 2014, the world’s most powerful computer is Tianhe-2 (Milky Way-2). This supercomputer is installed at the National University of Defense Technology (NUDT) in China and is the technological successor of Tianhe-1A, installed at the National Supercomputer Center in Tianjin, that was already No. 1 on the top500 list in November 2010.

(Nota: There is a new supercomputer more powerfull, you can read about Tianhe-2 here)

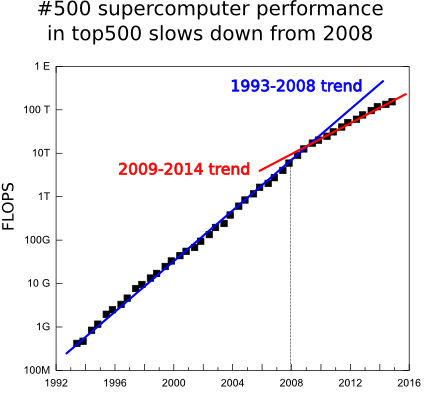

Before describing this colossus we must to mention that is the fourth consecutive time it is positioned in the first place of the top500.org semestral list, 2 years. This is an atypical situation. The computing evolves very fast and it is abnormal that in 2 years there has not been a faster supercomputer. But this is not the only worrying fact. In two years there have been only 2 new systems in the top 10 positions of the list and the age of this top 10 systems has not precedents. In addition, the power of the 500th system, the last one of the list, which use to have a smoother and continuous behavior, increased a 90% a year in the 1994-2008 range, but in the last 6 years it has dropped to a just 55% of increase. We hope this tendency will be broken soon thanks to the CORAL project in which the USA government is going to fund with 235 million dollars to build 2 pre-exascale (exaFLOPS=1000 PFLOPS) systems and with other 100 million dollars for technological development.

Before describing this colossus we must to mention that is the fourth consecutive time it is positioned in the first place of the top500.org semestral list, 2 years. This is an atypical situation. The computing evolves very fast and it is abnormal that in 2 years there has not been a faster supercomputer. But this is not the only worrying fact. In two years there have been only 2 new systems in the top 10 positions of the list and the age of this top 10 systems has not precedents. In addition, the power of the 500th system, the last one of the list, which use to have a smoother and continuous behavior, increased a 90% a year in the 1994-2008 range, but in the last 6 years it has dropped to a just 55% of increase. We hope this tendency will be broken soon thanks to the CORAL project in which the USA government is going to fund with 235 million dollars to build 2 pre-exascale (exaFLOPS=1000 PFLOPS) systems and with other 100 million dollars for technological development.

Tianhe-2 consists of 16,000 nodes each of which has 2 Intel Xeon Ivy Bridge processors and 3 Xeon Phi co-processors, to accelerate the calculations. This makes a total of 3,120,000 computing cores, 384,000 Xeon Ivy Bridge cores and 2,736,000 cores in the Phi coprocessors. It is a novelty that it has 3 coprocessors per node, usually there are one or two. These cores provide to Tianhe-2 a theoretical peak performance running mathematical operations of 54.9 PFLOPS (Peta = 10 ^ 15 Floating-point Operation Per Second, 1,000,000,000,000,000 mathematical operations per second) and with the LINPACK benchmark the real performance reaches 33 .9 PFLOPS, which almost doubles the previous record of the Titan supercomputer located at the Oak Ridge National Laboratory (ORNL) in Tennessee.

The interconnection network between the nodes, namely TH Express-2, is a proprietary design firstly installed in Tianhe-2 and aims to avoid communications bottlenecks implementing a bidirectional bandwidth of 16 GB/s, low latency and fat tree topology. Tianhe-2 uses the Kylin operating system based on Linux optimized for high performance computing and also developed by the NUDT. Being based on a standard Linux Kylin gives great flexibility to run many codes without specifically reprogram them.

Tianhe-2 consumes 17.8 MW, which is roughly equivalent to the consumption of 27,000 families. Nevertheless, it is energetically a very efficient supercomputer given the high number of FLOPS per watt it obtains. In the green500.org list of the energetically most efficient computers of the world Tianhe-2 is in the 32th position with 1,902 MFLOPS/W.

According to the NUDT Tianhe-2 will be dedicated to simulations, analysis and national security.

Most outstanding data

| Model | Own design |

| Nunber of cores |

3.120.000: 384.000 Xeon Ivy-Bridge cores y 2.736.000 Phi cores |

| Processor | Intel Xeon E-2692 with 12 cores at 2.2 GHz |

| Coprocessor | Intel Phi 31S1P with 57 cores at 1,1 GHz |

| Interconection | TH Express-2 |

| Operative System | Kylin |

| Theoretical FLOPS |

54,9 PetaFLOPS |

| Linpack FLOPS |

33.9 PetaFLOPS |

| Electric power |

17.8 MW |

| FLOPS/W | 1.9 GigaFLOPS |

Comentarios