Massively Parallel Systems Summer School (PUMPS-2016)

Introduction

Barcelona Computing Week 2014, July 11-15, at BSC/UPC, Barcelona.

The BSC/UPC has been awared by Nvidia as GPU Center of Excellence. The Programming and tUning Massively Parallel Systems Summer School (PUMPS) offers researchers and graduate students a unique opportunity to enrich their skills with cutting-edge technique and hands-on experience in developing applications for many-core processors with massively parallel computing resources like GPU accelerators.

The BSC/UPC has been awared by Nvidia as GPU Center of Excellence. The Programming and tUning Massively Parallel Systems Summer School (PUMPS) offers researchers and graduate students a unique opportunity to enrich their skills with cutting-edge technique and hands-on experience in developing applications for many-core processors with massively parallel computing resources like GPU accelerators.

Participants will have access to a multi-node cluster of GPUs, and will learn to program and optimize applications in languages such as CUDA and OmpSs. Teaching assistants will be available to help with assignments.

Important information

- Applications due: May 31

- Notification of acceptance: June 10

- Summer school dates: July 11-15, 2014

- Location: Barcelona Supercomputing Center / Computer Architecture Dept. at Universitat Politecnica de Catalunya, Barcelona, Spain. Room TDB.

Lecturers

- Distinguished Lectures:

- Wen-mei Hwu, University of Illinois at Urbana-Champaign.

- David Kirk, NVIDIA Fellow, former Chief Scientist, NVIDIA Corporation.

- Invited Lecturer: Juan Gómez Luna (Universidad de Cordoba).

- BSC/UPC Lecturers:

- Xavier Martorell

- Xabier Teruel

- .Teaching Assistants:

- Abdul Dakkak, Carl Pearson, Simon Garcia de Gonzalo, Marc Jorda, Pau Farre, Javier Bueno, Aimar Rodriguez.

The list of topics

- CUDA Algorithmic Optimization Strategies.

- Dealing with Sparse and Dynamic data.

- Efficiency in Large Data Traversal.

- Reducing Output Interference.

- Controlling Load Imbalance and Divergence.

- Acceleration of Collective Operations.

- Dynamic Parallelism and HyperQ.

- Debugging and Profiling CUDA Code.

- Multi-GPU Execution.

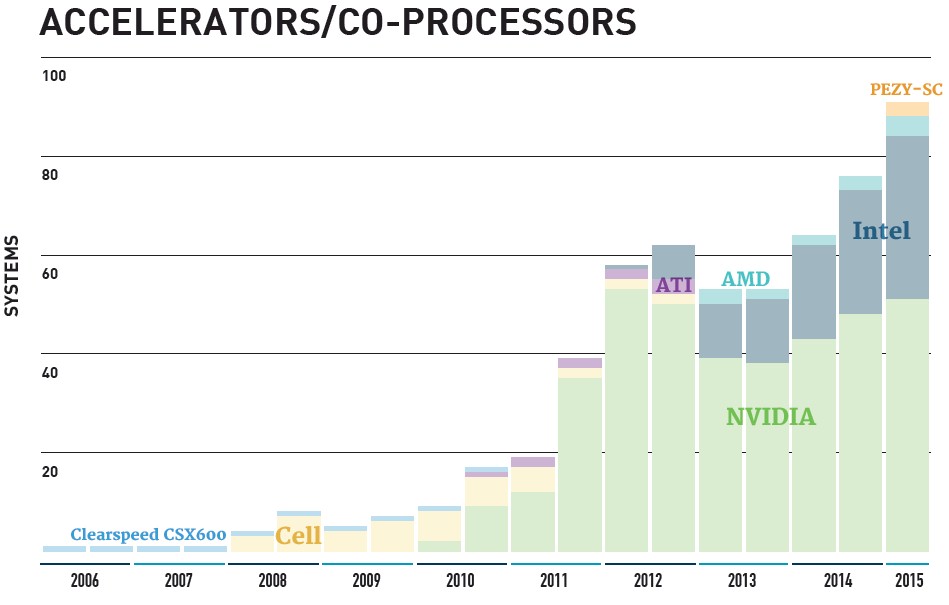

- Architecture Trends and Implications

- FORTRAN Interoperability and CUDA Libraries.

- Introduction to OmpSs and to the Paraver analysis tool.

- OmpSs: Leveraging GPU/CUDA Programming.

- Hands-on Labs: CUDA Optimizations on Scientific Codes. OmpSs Programming and Tuning.

More information

- Complete information, program and registration:PUMPS 2016 web page

- Contact: bcw2016@bcw.ac.upc.edu

Comentarios