Tianhe-2, continua por 5ª vez como el ordenador más potente del mundo

La nueva lista de los superordenadores más potentes del mundo muestra un estancamiento de la supercomputación a nivel mundial. De acuerdo a la nueva lista publicada hace unos días en top500.org de los ordenadores más potentes del mundo, a día de hoy Junio de 2015, el ordenador más potente del mundo continua siendo el chino Tianhe-2 (Vía Láctea-2). Este superordenador está instalado en la National University of Defense Technology (NUDT) de China y es el sucesor tecnológico de Tianhe-1A, instalado en el National Supercomputer Center en Tianjin que ya fué número 1 del top500 en la lista de Noviembre de 2010.

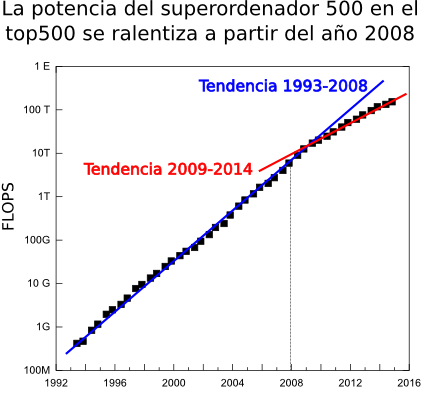

Antes de entrar a comentar los detalles técnicos de este coloso, comentar que es la quinta vez consecutiva que ocupa el número 1 en la lista semestral del top500, es decir, lleva 2 años y medio como el ordenador más potente del mundo e iguala el hito del Earth Simulator japones (2002-2004). Esta es una situación atípica. La potencia de los ordenadores avanza muy rápidamente y es anormal que en 2 años no haya salido ningún nuevo superordenador que haya podido superarlo. Pero no es el único dato preocupante. Ha este dato hay que añadir, por ejemplo, que entre los 10 primeros ordenadores de esta lista apenas lleva habiendo cambios, en las 4 últimas listas sólo ha habido 4 nuevas entradas. La edad de los sistemas en el top10 no tiene precedentes. Otro dato claro que nos habla sobre la ralentización es que para el último sistema de la lista, la posición 500 tiene un comportamiento más suave o continuo que el número 1, el incremento en la potencia en el periodo 1994-2008 era de un 90% anual mientras que el los últimos 6 años ha sido del 55%. En la última lista se aprecia también que la suma de la potencia de los 500 sistemas de la lista se ralentiza dado que durante los primeros años en los que se empezó a notar el cambio de tendencia en la cola de la lista en global aún se mantenía el crecimiento debido a los nuevos superordenadores en la parte alta. Esta tendencia parece que puede romper en un futuro cercano (2016-2018) pues el gobierno de EE.UU ha lanzado el proyecto CORAL con el que pretende desarrollar dos máquinas de nivel pre-exascala (exaFLOP=1000 PFLOPS) financiado con 235 millones de dolares y otros 100 millones en desarrollo tecnológico y el Presidente Obama a lanzado una iniciativa a cinco años para impulsar la supercomputación.

Antes de entrar a comentar los detalles técnicos de este coloso, comentar que es la quinta vez consecutiva que ocupa el número 1 en la lista semestral del top500, es decir, lleva 2 años y medio como el ordenador más potente del mundo e iguala el hito del Earth Simulator japones (2002-2004). Esta es una situación atípica. La potencia de los ordenadores avanza muy rápidamente y es anormal que en 2 años no haya salido ningún nuevo superordenador que haya podido superarlo. Pero no es el único dato preocupante. Ha este dato hay que añadir, por ejemplo, que entre los 10 primeros ordenadores de esta lista apenas lleva habiendo cambios, en las 4 últimas listas sólo ha habido 4 nuevas entradas. La edad de los sistemas en el top10 no tiene precedentes. Otro dato claro que nos habla sobre la ralentización es que para el último sistema de la lista, la posición 500 tiene un comportamiento más suave o continuo que el número 1, el incremento en la potencia en el periodo 1994-2008 era de un 90% anual mientras que el los últimos 6 años ha sido del 55%. En la última lista se aprecia también que la suma de la potencia de los 500 sistemas de la lista se ralentiza dado que durante los primeros años en los que se empezó a notar el cambio de tendencia en la cola de la lista en global aún se mantenía el crecimiento debido a los nuevos superordenadores en la parte alta. Esta tendencia parece que puede romper en un futuro cercano (2016-2018) pues el gobierno de EE.UU ha lanzado el proyecto CORAL con el que pretende desarrollar dos máquinas de nivel pre-exascala (exaFLOP=1000 PFLOPS) financiado con 235 millones de dolares y otros 100 millones en desarrollo tecnológico y el Presidente Obama a lanzado una iniciativa a cinco años para impulsar la supercomputación.

Tianhe-2 está formado por 16.000 nodos cada uno de los cuales tiene 2 procesadores Intel Xeon Ivy Bridge y 3 coprocesadores para acelerar los cálculos Xeon Phi. Esto hace un total de 3.120.000 cores de cálculo, 384.000 Xeon y 2.736.000 cores en los coprocesadores Phi. Es una novedad que tenga 3 coprocesadores por nodo pues lo habitual son uno o dos. Estos cores le dotan de un rendimiento teórico ejecutando operaciones matemáticas de 54,9 PFLOPS (Peta=10^15 FLoating-point Operation Per Second, 1.000.000.000.000.000 operaciones matemáticas por segundo) y en el benchmark LINPACK alcanza un rendimiento real de 33,9 PFLOPS, lo cual es casi el doble que el anterior número 1 Titan.

La red de interconexión entre los nodos es un diseño propio, TH Express-2, y trata de evitar que las comunicaciones sean un cuello de botella gracias al ancho de banda bidireccional de 16 GB/s, baja latencia y topología fat tree. Tianhe-2 usa el sistema operativo Kylin, basado en Linux, y también desarrollado por la NUDT y optimizado para HPC. El hecho de estar basado en un estándar como Linux le da mucha flexibilidad a la hora de ejecutar muchos códigos sin necesidad de reprogramarlos específicamente.

Tianhe consume 17.8 MW, que equivale aproximadamente al consumo de 27.000 familias, a pesar de lo cual es también en un supercomputador muy eficiente dado el alto número de FLOPS por watio que realiza, aunque cuando se anuncie la lista green500.org de los computadores energéticamente más eficientes del mundo probablemente ocupará entorno al puesto 40.

De acuerdo a la NUDT Tianhe-2 estará dedidado a aplicaciones de simulación, análisis y seguridad nacional.

Datos más relevantes

| Marca y modelo | Diseño propio |

| Nº de cores | 3.120.000: 384.000 cores xeon y 2.736.000 cores Phi |

| Procesador | Intel Xeon E-2692 de 12 cores a 2.2 GHz |

| Coprocesador | Intel Phi 31S1P de 57 cores a 1,1 GHz |

| Interconexión | TH Express-2 |

| Sistema Operativo | Kylin |

| FLOPS teóricos | 54,9 PetaFLOPS |

| FLOPS Linpack | 33.9 PetaFLOPS |

| Potencia eléctrica | 17.8 MW |

| FLOPS/W | 1.9 GigaFLOPS |

El

El

Comentarios