-

In memoriam: Arturo Muga

-

Violeta Pérez Manzano: «Si mi voz llega a una sola persona gitana y eso le inspira, ya habré cumplido»

-

In memoriam: German Gazteluiturri Fernández

-

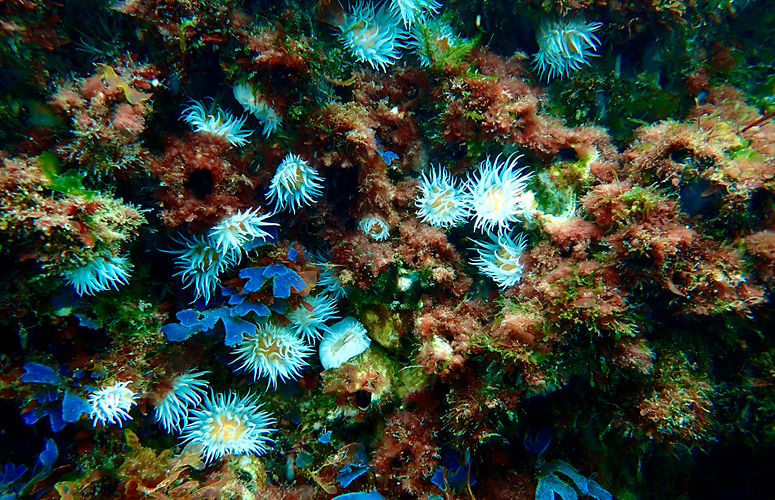

El aumento de la temperatura superficial del mar ha provocado profundas transformaciones en las comunidades de macroalgas

-

Azúcar y edulcorantes ¿Qué debo saber?

Daniel Innerarity

Las expectativas democráticas de la inteligencia artificial

Catedrático de Filosofía Política, investigador Ikerbasque en la UPV/EHU, director del Instituto de Gobernanza Democrática y profesor visitante del Instituto Europeo de Florencia

- Cathedra

Fecha de primera publicación: 19/05/2022

Con el incremento de la complejidad social aumenta el número de las tareas que es necesario confiar a procedimientos de cálculo, pero la actual automatización no es un aumento cuantitativo sino que implica un salto cualitativo; la algoritmización de tantas decisiones políticas no obedece a una lógica instrumental (humanos que emplean instrumentos) sino, hasta cierto punto, a una lógica de sustitución (humanos que renuncian a decidir) y autonomización (máquinas que son capaces de decidir por ellas mismas). Ese salto implica un rediseño institucional de la política, una enorme promesa y una no menos inquietante amenaza. Ciertas decisiones —quién sabe si demasiadas o, tal vez, todas en el futuro— no son adoptadas únicamente por los seres humanos sino confiadas, en todo o en parte, a sistemas que procesan datos y dan lugar a un resultado que no es plenamente pronosticable.

Es necesario pensar qué quiere decir autogobierno democrático y qué sentido tiene la libre decisión política en esta nueva constelación. Se trataría de desarrollar una teoría de la decisión democrática en un entorno mediado por la inteligencia artificial, elaborar una teoría crítica de la razón automática. Necesitamos una filosofía política de la inteligencia artificial, una aproximación que no puede ser cubierta ni por la reflexión tecnológica ni por los códigos éticos.

Tenemos que prestar una mayor atención a las disrupciones que esta nueva constelación (sistemas cada vez más inteligentes, una tecnología más integrada y una sociedad más cuantificada) va a producir en nuestra forma de organización democrática. Ciertas decisiones ya no son adoptadas únicamente por los seres humanos sino confiadas, en todo o en parte, a sistemas que procesan datos y dan lugar a un resultado que no era plenamente pronosticable. ¿Qué pasa con la libre decisión –que es el núcleo normativo de la democracia- en entornos automatizados? ¿Quién decide cuándo decide un algoritmo? El nuevo entorno digital nos va a obligar a pensar nuevamente algunas de las categorías básicas de la política y a gobernar este mundo con otros instrumentos. Estamos hablando de tecnologías especialmente sofisticadas y complejas, en las que sirven de muy poco genéricos llamamientos a su “humanización” o ciertos códigos éticos que parecen desconocer su naturaleza. Máquinas que aprenden, análisis de datos en proporciones gigantescas o la actual proliferación de sistemas de decisión automatizada no son dispositivos que puedan regularse con procedimientos simples de intervención, pero eso es una disculpa para no hacer nada sino para que las instituciones regulatorias actúen, por lo menos, con la misma inteligencia que aquello que tienen obligación de regular.

El que estemos asistiendo a un cambio brutal en nuestro entorno tecnológico, de consecuencias en buena parte imprevisibles, explica el hecho de que no sepamos muy bien cómo diagnosticar la situación y el escenario se haya llenado de valoraciones extremas, poco matizadas, de entusiasmo desmedido o de tintes apocalípticos, formuladas también por intelectuales de los que tenemos derecho a esperar un juicio más sereno. Estas valoraciones han ido evolucionando en un plazo de tiempo muy corto. Hace relativamente poco estábamos celebrando el potencial democratizador de la red, en lo que se conoció como las primaveras árabes y el acceso universal al espacio público, mientras que ahora estamos atemorizados con los bots, las injerencias electorales y la desinformación. El número de septiembre de 2018 de la ‘MIT Technology Review’ fue dedicado a la cuestión de si la tecnología estaba amenazando nuestra democracia y The Economist del 18 de diciembre de 2019 ya hablaba de un “aithoritarianism”, de un autoritarismo de la inteligencia artificial que podría destruir las instituciones democráticas. Eso explica que haya descripciones tan enfrentadas de la situación en la que nos encontramos: mientras unos festejan la llegada de una política sin prejuicios ideológicos, otros nos advierten sobre el final de la democracia. Hay quien asegura que la nueva tecnología vendría a resolver los problemas ante los que ha fracasado la vieja política; otros hacen responsable al nuevo entorno tecnológico de la pérdida de capacidad de gobierno sobre los procesos sociales y la des-democratización de las decisiones políticas.

El interrogante fundamental que se nos plantea es qué lugar ocupa la decisión política en una democracia algorítmica. La democracia es libre decisión, voluntad popular, autogobierno. ¿Hasta qué punto es eso posible y tiene sentido en los entornos hiperautomatizados, algorítmicos, que anuncia la inteligencia artificial? La democracia representativa es un modo de articular el poder político que lo atribuye a un órgano determinado, y de acuerdo con una cadena de responsabilidad y legitimidad en la que se verifica el principio de que todo el poder procede del pueblo. Desde esta perspectiva, la introducción de sistemas inteligentes autonomizados aparece como algo problemático.

La tendencia general a un pilotaje automatizado de los asuntos humanos no es solo un aumento cuantitativo de los instrumentos que tenemos a nuestra disposición sino una transformación cualitativa de nuestro ser en el mundo, un mundo en cuyo centro ya no nos encontramos. Con la automatización podríamos estar programando nuestra propia obsolescencia. Marvin Minsky afirmaba que deberíamos considerarnos unos afortunados si en el futuro las máquinas inteligentes nos tienen como animales de compañía. ¿Cómo conseguir que no se cumpla esa siniestra profecía y los seres humanos tengamos una cierta soberanía en esos nuevos entornos tecnológicos?

Cuando hablamos de una inteligencia artificial centrada en el ser humano y democrática hay básicamente dos estrategias que permiten pensar en una reapropiación de los procesos automatizados de decisión: el diseño del ecosistema humanos-máquinas y la transparencia.

En primer lugar, se trataría de diseñar la mejor presencia de los humanos en procesos caracterizados por una enorme complejidad, teniendo en cuenta que se trata de un equilibrio que incluye inevitablemente una cierta tensión: hemos de pensar ese ecosistema de modo que los humanos no quedemos subordinados (algo incompatible con nuestro ideal de autodeterminación) y al mismo tiempo debemos intervenir en las máquinas sin arruinar su performatividad. Con eso no estoy planteando una solución sino llamando la atención sobre un problema que a veces pasan por alto algunas soluciones éticas y humanísticas que no son más que meras exhortaciones.

La otra estrategia de humanización de la tecnología es a través de la transparencia como posibilidad de explicar, entender y exigir responsabilidad a la inteligencia artificial por parte de los humanos. Aquí también hay soluciones y exigencias que parecen no tener en cuenta la complejidad de los sistemas o las limitaciones subjetivas de comprensión. La gran tarea a ese respecto gira en torno a nociones que son más realistas que la transparencia, como la explicabilidad, la generación de confianza o la idea de que entender no es tanto un asunto subjetivo sino colectivo, que tiene que ser facilitado y regulado institucionalmente.

Los seres humanos hemos sido capaces de inventar, con mayor o menor fortuna, procedimientos e instituciones democráticas para realidades muy distintas: para las ciudades griegas y para las ciudades-estado del renacimiento, para los estados nacionales y para alguna de nuestras instituciones globales como la Unión Europea. ¿Estamos tan seguros de que eso no se puede conseguir en la nueva constelación digital? Creo que no tenemos derecho a dejar de intentarlo mientras no se demuestre que es un objetivo imposible.