Göran Kauermann es un reconocido investigador en el campo de la estadística. Es Catedrático de Estadística en Alemania y, desde 2011, ocupa la Cátedra de Estadística en Economía, Administración de Empresas y Ciencias Sociales en la Ludwig-Maximilians-Universität München (LMU). También es el Portavoz del Programa Elite Master en Ciencias de Datos en la LMU.

-

In memoriam: Arturo Muga

-

Violeta Pérez Manzano: «Si mi voz llega a una sola persona gitana y eso le inspira, ya habré cumplido»

-

In memoriam: German Gazteluiturri Fernández

-

Azúcar y edulcorantes ¿Qué debo saber?

-

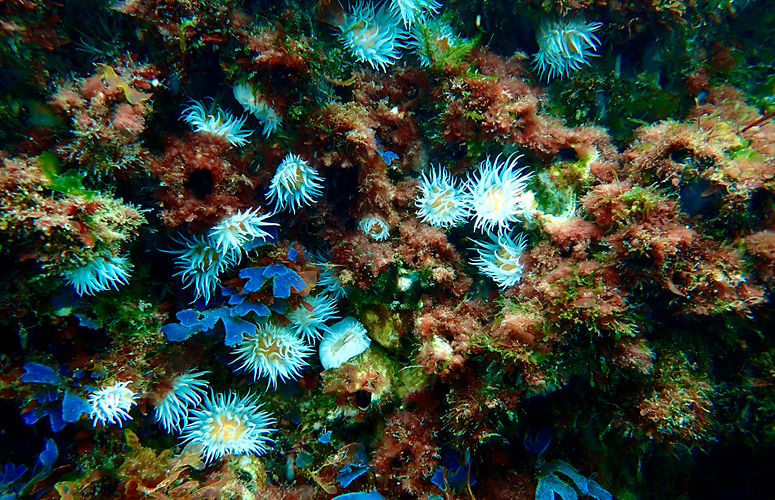

El aumento de la temperatura superficial del mar ha provocado profundas transformaciones en las comunidades de macroalgas

Göran Kauermann, catedrático de Estadística

«Los desafíos de la era del Big Data han incrementado el prestigio de la estadística»

- Entrevista

Fecha de primera publicación: 22/02/2018

El viernes 23 de febrero impartirá un seminario sobre Estadística Aplicada organizado por el Grupo de Estadística Aplicada del Centro Vasco de Matemática Aplicada (BCAM) y los Departamentos de Economía Aplicada III (Econometría y Estadística) y Matemática Aplicada, Estadísticas y Operaciones de la UPV / EHU. La sesión, titulada "Statistical models for network data analysis – a gentle introduction (Modelos estadísticos para el análisis de datos en red: una introducción que todos podremos comprender", forma parte de una serie de seminarios que pretenden servir como base común y lugar de encuentro para el debate y la difusión de la Estadística y sus posibles aplicaciones. Hemos tenido la oportunidad de entrevistar a Kauermann antes de su presentación del viernes y esto es lo que nos ha contado sobre la Estadística, el Big Data y el Análisis de Datos en Red:

Gracias a los avances tecnológicos actualmente se recopila una cantidad de datos enormemente mayor. ¿Cómo ayuda la estadística a analizarla?

La avalancha de datos y los desafíos de la era del Big Data han incrementado el prestigio de la estadística. El razonamiento estadístico y el pensamiento estadístico son importantes, mucho más allá de las áreas clásicas de la estadística. Esto ha dado lugar al nuevo campo científico de la Ciencia de Datos. Aunque la definición exacta de Ciencia de Datos aún no está consolidada, en mi opinión, es una confluencia de la estadística y la informática. Cada disciplina aborda el análisis de datos desde ángulos diferentes. Si bien la estadística busca responder a la pregunta "¿qué está pasando?", las herramientas de análisis de datos de la informática (como el aprendizaje automático) se centran en la predicción, es decir, abordan la pregunta "¿qué sucede después?". Ambos enfoques son necesarios y útiles, dependiendo de la pregunta y el problema. En otras palabras, sí, la estadística puede y debe ayudar guiar la revolución digital, pero solo puede tener éxito si lo hace de la mano de la informática en la nueva dirección de la Ciencia de Datos. Dicho esto, también quiero destacar que los campos tradicionales de la estadística (estadística médica, econometría, etc.) siguen siendo igual de importantes que antes.

¿Es más fácil trabajar con grandes cantidades de datos o requiere métodos más complejos?

Ciertamente, la estadística debe lidiar con una cantidad masiva de datos, y algunas de nuestras rutinas simplemente no funcionan en Big Data. Pero no me parece que se requiera de métodos más complejos. En retrospectiva, los métodos estadísticos siempre han estado limitados por el poder y la flexibilidad computacional, comenzando por la computación matricial simple en los años 50 y ahora con métodos más complejos en la actual era del big data. Sin embargo, algunas ideas estadísticas y computacionales antiguas han resurgido. Los métodos tensoriales y las aproximaciones de álgebra lineal (por ejemplo, la descomposición en valores singulares) son muy útiles. En lugar de analizar todos los datos, se opta por utilizar alguna aproximación. El concepto matemático de suficiencia adquiere un nuevo significado. En lugar de trabajar con todos los datos, uno simplemente calcula el estadístico suficiente, que funciona incluso con datos a gran escala. Y después de todo, el muestreo aparece en una nueva faceta, ¿por qué analizar todos los petabytes de datos en lugar de simplemente extraer una muestra de ellos? Estos no son métodos nuevos o más complejos, pero se adaptan y modifican a tenor de las nuevas y más complejas constelaciones de datos.

Trabaja en Análisis de Datos en Red. ¿Cómo explicaría en qué consiste?

Los datos en red tienen una estructura muy simple. Una serie de actores (nodos) interactúan entre sí (aristas). La interacción puede ser de amistad, que no es más que una codificación cero / uno (1 = amistad entre dos nodos, 0 = sin amistad), o puede ser una interacción de valor, por ejemplo, un intercambio entre los actores. Y a pesar de que la estructura es simple, el modelado de este tipo de datos es complejo si se supone que la existencia de una arista depende de la existencia de otras aristas. Es decir, si las aristas, consideradas como variables aleatorias, son mutuamente dependientes. La forma más sencilla de entender esto es una red de amistad. La posibilidad de que dos actores construyan una amistad puede depender del número de amigos que estos dos actores tienen en común. En otras palabras, depende de otras aristas. Tal dependencia mutua dificulta el ejercicio de modelado.

¿Qué tipo de datos en red analiza generalmente? ¿Podría darnos algún ejemplo?

El ámbito clásico del análisis de datos en red proviene de las ciencias sociales, donde las redes representan redes de amistad. Sin embargo, los modelos y métodos no están limitados a este tipo de red. Otros ejemplos son redes comerciales, redes de interacción de científicos, redes de flujo, etc.

¿Qué tipo de modelos estadísticos utiliza para trabajar con ese tipo de datos?

El caballo de batalla en el análisis estadístico de datos en red es el modelo de grafos aleatorios exponenciales. Considera la red como una matriz aleatoria con entradas 0/1 y modela la probabilidad de dicha matriz en forma de una familia de distribución exponencial. Esto permite realizar una interpretación intuitiva pero adolece de trabas numéricas. Esto se ejemplificará en la charla que daré el viernes.

Se puede encontrar más información sobre el seminario y el programa completo en la web de BCAM.