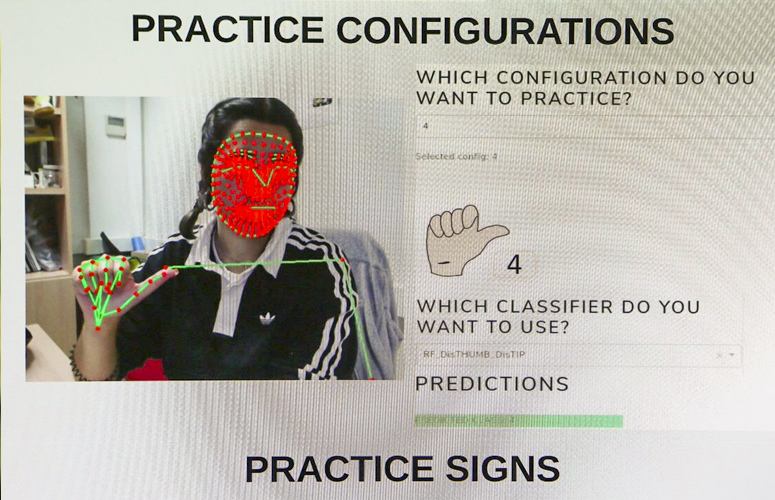

A pesar de los esfuerzos que se han realizados, las personas con problemas de audición tienen dificultades para comunicarse en entornos sin un intérprete. Últimamente se han desarrollado diferentes enfoques para tratar de resolver este problema. Un grupo de investigadores de la Facultad de Informática de la UPV/EHU ha desarrollado un sistema de reconocimiento de la lengua de signos argentina que utiliza puntos de referencia de la mano extraídos de vídeos con el fin de distinguir entre diferentes signos. Han realizado varios experimentos de los que se han obtenido resultados prometedores.

-

In memoriam: Arturo Muga

-

Violeta Pérez Manzano: «Si mi voz llega a una sola persona gitana y eso le inspira, ya habré cumplido»

-

In memoriam: German Gazteluiturri Fernández

-

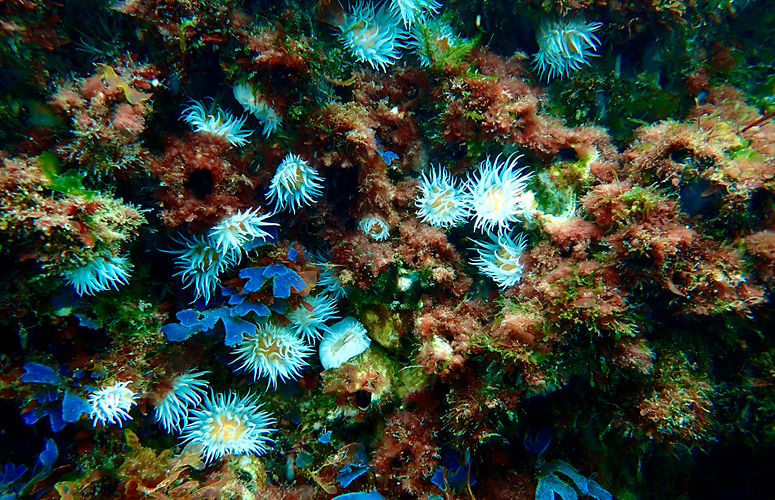

El aumento de la temperatura superficial del mar ha provocado profundas transformaciones en las comunidades de macroalgas

-

Azúcar y edulcorantes ¿Qué debo saber?

Avances en la mejora de la comunicación de las personas con problemas de audición

Un grupo de investigadores de la Facultad de Informática de la UPV/EHU trabajan en la identificación automática del lenguaje de signos, utilizando puntos de referencia de la mano extraídos de vídeos

- Investigación

Fecha de primera publicación: 24/11/2022

El estudio llevado a cabo por los investigadores Itsaso Rodríguez-Moreno, José María Martínez-Otzeta, Izaro Goienetxea y Basilio Sierra ha sido publicado recientemente en la revista científica Plos One. “Según los datos de la Organización Mundial de la Salud-comenta Basilio Sierra, catedrático del Departamento de Ciencias de la Computación e Inteligencia Artificial-, más del 5% de la población mundial tiene problemas de audición. Esto supone unos 466 millones de personas (432 millones de adultos y 34 millones de niños), y se prevé que esta cantidad aumente. Para 2050 se espera que alrededor de 700 millones de personas (una de cada diez personas) sufran deficiencias auditivas. Entre estas personas, más o menos 70 millones utilizan una de las más de 300 lenguas de signos que existen como primera lengua. Sin embargo, como el conocimiento de las lenguas de signos no está extendido por todo el mundo, estas personas suelen tener dificultades para comunicarse en diferentes escenarios, y su interacción en la vida diaria se complica cuando no hay un intérprete que les ayude con la traducción. Para tratar de resolver estos problemas, últimamente se han desarrollado muchos enfoques diferentes en el campo del reconocimiento automático del lenguaje de signos. Algunos de estos enfoques son un poco intrusivos, ya que requieren que el signante (persona que usa el lenguaje de signos) utilice algún tipo de dispositivo para que el sistema sea capaz de interpretar lo que está diciendo.”

“Las lenguas de signos-explica Itsaso Rodríguez, estudiante de doctorado-, como lenguas orales, tienen sus propias estructuras lingüísticas y son bastante difíciles de traducir a lenguas habladas debido a diferentes aspectos. Cada lengua de signos está compuesta por miles de signos diferentes que muchas veces difieren por pequeños cambios. Por ejemplo, algunos signos tienen la misma configuración de manos, pero diferente orientación. Además, a veces el significado de un signo puede cambiar según el contexto o la frase en la que se utilice. La expresión facial también es crucial para diferenciar algunos de los signos, lo que es muy importante, por ejemplo, a la hora de hacer frases interrogativas. Por lo tanto, algunos signos difieren sólo en pequeños detalles, como la configuración de la mano, el movimiento, la posición, la expresión facial o incluso el contexto.”

Basado en vídeo

Sin embargo, añade Basilio Sierra, varios signos se parecen mucho a los gestos que realizaría un oyente no experto para describir una acción. Y, en la mayoría de los casos la relación signo-objeto es arbitraria y no tienen ninguna referencia visual. “Otras características de las lenguas de signos son, por ejemplo, que el orden de las palabras puede ser diferente según el contexto o que algunos verbos no se signan. También hay que tener en cuenta la ortografía dactilar, en la que las palabras se deletrean si no se conoce el signo de esa palabra. El deletreo con los dedos se utiliza sobre todo para los nombres propios. Hay muchas otras características que hacen que el reconocimiento del lenguaje de signos sea una tarea compleja, aunque no mencionamos todas en el estudio”. Así, en este trabajo se presenta un enfoque para el reconocimiento de la lengua de signos basado en vídeo. “Como primer paso del proceso, se componen unas señales con las posiciones extraídas por MediaPipe (solución de detección facial ultrarápida), que representan un conjunto de articulaciones de la mano que está realizando el signo. A continuación, estas señales se transforman utilizando el algoritmo Common Spatial Patterns, un algoritmo de reducción de la dimensionalidad ampliamente utilizado en las señales de electroencefalograma. Common Spatial Patterns también se ha aplicado en el campo de la electrocardiografía, la electromiografía o incluso en imágenes astronómicas para la detección de planetas, y recientemente se ha utilizado en tareas de reconocimiento de acciones en vídeo obteniendo resultados alentadores. Este enfoque permite un cálculo de forma cerrada y por lo tanto no es necesario decidir los criterios de terminación como ocurre en métodos iterativos ampliamente aplicados, por ejemplo, el descenso de gradiente en el aprendizaje profundo.”

En el artículo publicado en la revista científica Plos One se presenta un enfoque de reconocimiento de la lengua de signos, en el que se utilizan vídeos de un conjunto de datos de la lengua de signos argentina. “Para cada fotograma de vídeo se obtienen varios puntos de referencia de la mano mediante la mencionada tecnología MediaPipe. Estos puntos de referencia de la mano se utilizan para crear un conjunto de señales para cada vídeo. El algoritmo ya comentado Common Spatial Patterns se utiliza para transformar estas señales y después de extraer algunas características de las mismas (valores de varianza, máximo, mínimo y rango intercuartílico) se realiza la clasificación. Para la clasificación se han utilizado diferentes clasificadores. Hay que mencionar que el enfoque presentado no es intrusivo, no es necesario colocar ningún tipo de dispositivo a los signantes, lo que hace que el sistema sea más cómodo para ellos. Los resultados obtenidos se sitúan entre el 0:90 y el 0:95, alcanzando valores de precisión más altos tras convertir los vídeos originales al espacio de color blanco y negro. Por lo tanto, los resultados de clasificación son prometedores.”, concluye Itsaso Rodríguez.

Referencia bibliográfica

- Sign language recognition by means of common spatial patterns: An analysis.

- PLoS ONE

- DOI: 10.1371/journal.pone.0276941