Archive

HPCren erabilera PAYPALen

Breve revisión de la computación en GPU, evolución en Nvidia

Autor: Luis Fer Coca, alumno del centro IEFPS Elorrieta-Erreka Mari en prácticas en el IZO-SGI.

La GPU o Unidad de Procesamiento de Gráficos es un coprocesador dedicado al procesamiento de gráficos, que sirve para aligerar la carga de trabajo del procesador en el procesamiento de los gráficos a mostrar en pantalla.

Pero en 2007 surgió el cálculo acelerado en la GPU, que lo podemos definir como el uso de una unidad de procesamiento gráfico en combinación con la CPU para acelerar los análisis y cálculos de aplicaciones de investigación, empresa, consumo, ingeniería,etc. Desde entonces, las GPU aceleradoras han pasado a instalarse en centros de datos de laboratorios gubernamentales, universidades, grandes compañías y PYMEs de todo el mundo.

El uso y mercado de las GPU, ya no es sólo como tarjetas gráficas para disfrutar de los últimos videojuegos con la mejor calidad, si no que también en el sector del HPC con ordenadores de alto rendimiento que ejecutan miles de millones de operaciones, y donde las GPUs hacen determinadas operaciones más rápidas que una CPU del mismo rango.

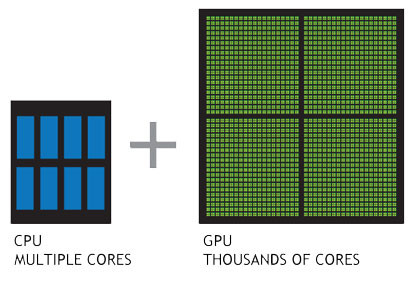

La GPU frente al procesador

Una forma sencilla de entender la diferencia entre el procesador y la GPU es comparar la forma en que procesan las tareas. Un procesador está formado por varios núcleos de propósito general, mientras que una GPU consta de millares de núcleos más pequeños y eficientes, diseñados para ejecutar múltiples operaciones matemáticas simultáneamente.

Una forma sencilla de entender la diferencia entre el procesador y la GPU es comparar la forma en que procesan las tareas. Un procesador está formado por varios núcleos de propósito general, mientras que una GPU consta de millares de núcleos más pequeños y eficientes, diseñados para ejecutar múltiples operaciones matemáticas simultáneamente.

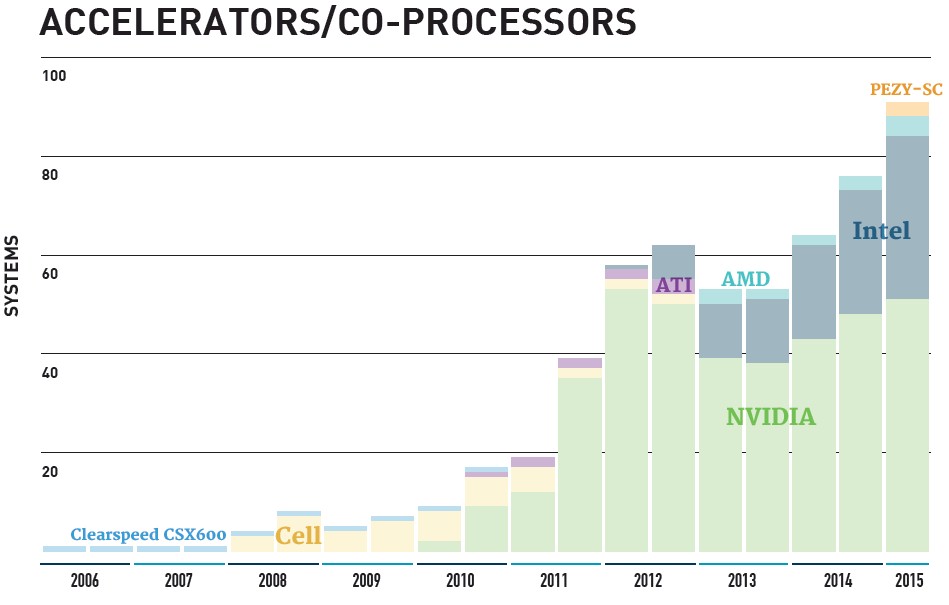

Las GPUs en el Top500

Como podemos observar en la gráfica del Top500, entre los sistemas con coprocesadores, las GPU aceleradoras de NVIDIA y AMD dominan actualmente el Top500, sobre los Intel Phi y el nuevo acelerador del fabricante de chips japoneses PEZY COMPUTING.Asímismo observamos el crecimiento que este tipo de tecnologías están teniendo en el mundo del HPC.

Evolución de las GPU Nvidia

Las claves que han hecho la plataforma de aceleración computacional de NVIDIA las más popular para cálculo científico es que combinan las GPUs aceleradoras, el modelo de procesamiento paralelo CUDA, un amplio ecosistema de desarrolladores, proveedores de software y fabricantes de sistemas para HPC y el haber sido una de las pioneras.

Recientemente, NVDIA presentó la nueva Tesla P100 y es oficialmente la GPU más potente del mercado, orientada al sector de los HPC, forma parte de la nueva generación de chips Pascal, que sucede a la generación Maxwell. Está basado en el nuevo proceso de fabricación FinFET de 16 nm, lo que ha permitido multiplicar por dos la densidad de transistores, usando un 70% menos de energía al mismo tiempo. Es una GPU más potente, pero también más eficiente.

En la tabla se observa evolución de algunas GPUs ejemplo de Nvidia.

| Arquitectura | Fermi | Kepler | Pascal | |

| GPU | M2050 | K20 | K80 | P100 |

| Procesadores | 448 | 2496 | 4992 | 3584 |

| Velocidad (MHz) | 1150 | 706 | 562 | 1328 |

| RAM (GB) | 3 | 5 | 24 | 16 |

| Rendimiento en precisión simple | 1.03 TFLOPS | 3.52 TFLOPS | 8.74 TFLOPS | 10.6 TFLOPS |

| Rendimiento en doble precisión | 515 GFLOPS | 1.17 TFLOPS | 2.91 TFLOPS | 5.3 TFLOPS |

| Número de transistores (millones) | 3.1 | 7.1 | 14.2 | 15.3 |

| Consumo eléctrico | 225W | 225W | 300W | 300W |

GPUs Nvidia en el Servicio de Cálculo

El Servicio de Cálculo de la UPV/EHU ha ido adquiriendo esta tecnología desde 2010 para ofrecer un pequeño entorno de producción y test en este campo a los investigadores, actualmente tiene 4 GPUs Fermi C2050, 4 Fermi C2070 y dos Kepler K20. Igualmente está prevista la adquisición de GPUs Kepler k80.

Conclusión

Las tecnologías de coprocesamiento, entre ellas las GPUs, siguen en continuo desarrollo permitiendo el progreso del cálculo científico y preservando la posición del mismo como una herramienta muy útil para la investigación e innovación en infinidad de campos.

Referencias

http://www.nvidia.es/object/tesla-high-performance-computing-es.html

http://wccftech.com/nvidia-pascal-gpu-gtc-2016/

http://www.omicrono.com/2016/04/nvidia-tesla-100/

http://www.almatech.es/nvidia-incorpora-gpu-a-la-arquitectura-kepler/

Installing Tensorflow 0.7 in Red Hat Enterprise Linux Server 6.4 with GPUs

Red Hat Enterprise Linux Server 6.4 has already a quite old OS, and it is not possible to install the precompiled tensorflow packages with pip and so on. So we had to compile it.

The instructions we follow are based on this document:

https://www.tensorflow.org/versions/r0.7/get_started/os_setup.html#installation-for-linux

We want to install it to be run on GPUs, so first we need to register in nvidia

https://developer.nvidia.com/cudnn

to install the cuDNN libraries. Download and copy the include and libraries to the corresponding cuda version directories.

In order to compile tensorflow from source, we first need to compile the bazel compiler.

1.- Installing Bazel

The first problem is that the gcc/g++ compiler in RHELS 6.4 is old, 4.4.7, and at least 4.8 is required. We did install RH devtoolset-3 which provides 4.9.2 version of gcc/g++. We also need Java JDK 8 or later.

Now, we can download bazel:

git clone https://github.com/bazelbuild/bazel.git

And we set up our environment to compile bazel:

export JAVA_HOME=/software/jdk1.8.0_20

export PATH=/opt/rh/devtoolset-3/root/usr/bin:/software/anaconda2/bin:/software/jdk1.8.0_20/bin:$PATH

export LD_LIBRARY_PATH=/opt/rh/devtoolset-3/root/usr/lib64:/opt/rh/devtoolset-3/root/usr/lib:/software/anaconda2/lib64:/software/anaconda2/lib:$LD_LIBRARY_PATH

Then, we have to modify the bazel/tools/cpp/CROSSTOOL file to choose the commands from devtoolset-3 instead of the default ones, in the toolchain_identifier: “local_linux”

toolchain {

abi_version: “local”

abi_libc_version: “local”

builtin_sysroot: “”

compiler: “compiler”

host_system_name: “local”

needsPic: true

supports_gold_linker: false

supports_incremental_linker: false

supports_fission: false

supports_interface_shared_objects: false

supports_normalizing_ar: false

supports_start_end_lib: false

supports_thin_archives: false

target_libc: “local”

target_cpu: “local”

target_system_name: “local”

toolchain_identifier: “local_linux”

tool_path { name: “ar” path: “/opt/rh/devtoolset-3/root/usr/bin/ar” }

tool_path { name: “compat-ld” path: “/opt/rh/devtoolset-3/root/usr/bin/ld” }

tool_path { name: “cpp” path: “/opt/rh/devtoolset-3/root/usr/bin/cpp” }

tool_path { name: “dwp” path: “/opt/rh/devtoolset-3/root/usr/bin/dwp” }

tool_path { name: “gcc” path: “/opt/rh/devtoolset-3/root/usr/bin/gcc” }

cxx_flag: “-std=c++0x”

linker_flag: “-lstdc++”

linker_flag: “-B/opt/rh/devtoolset-3/root/usr/bin/”# TODO(bazel-team): In theory, the path here ought to exactly match the path

# used by gcc. That works because bazel currently doesn’t track files at

# absolute locations and has no remote execution, yet. However, this will need

# to be fixed, maybe with auto-detection?

cxx_builtin_include_directory: “/opt/rh/devtoolset-3/root/usr/lib/gcc/”

cxx_builtin_include_directory: “/opt/rh/devtoolset-3/root/usr/include”

tool_path { name: “gcov” path: “/opt/rh/devtoolset-3/root/usr/bin/gcov” }# C(++) compiles invoke the compiler (as that is the one knowing where

# to find libraries), but we provide LD so other rules can invoke the linker.

tool_path { name: “ld” path: “/opt/rh/devtoolset-3/root/usr/bin/ld” }tool_path { name: “nm” path: “/opt/rh/devtoolset-3/root/usr/bin/nm” }

tool_path { name: “objcopy” path: “/opt/rh/devtoolset-3/root/usr/bin/objcopy” }

objcopy_embed_flag: “-I”

objcopy_embed_flag: “binary”

tool_path { name: “objdump” path: “/opt/rh/devtoolset-3/root/usr/bin/objdump” }

tool_path { name: “strip” path: “/opt/rh/devtoolset-3/root/usr/bin/strip” }

compilation_mode_flags {

mode: DBG

# Enable debug symbols.

compiler_flag: “-g”

}

compilation_mode_flags {

mode: OPT

# No debug symbols.

# Maybe we should enable https://gcc.gnu.org/wiki/DebugFission for opt or even generally?

# However, that can’t happen here, as it requires special handling in Bazel.

compiler_flag: “-g0”# Conservative choice for -O

# -O3 can increase binary size and even slow down the resulting binaries.

# Profile first and / or use FDO if you need better performance than this.

compiler_flag: “-O2”# Disable assertions

compiler_flag: “-DNDEBUG”# Removal of unused code and data at link time (can this increase binary size in some cases?).

compiler_flag: “-ffunction-sections”

compiler_flag: “-fdata-sections”

}

linking_mode_flags { mode: DYNAMIC }

}

Now, we can compile it with the command:

./compile.sh

It will create a binary bazel, that we will use now to compile tensorflow.

2.- Tensorflow

Download Tensorflow

git clone –recurse-submodules https://github.com/tensorflow/tensorflow

We define the environment to compile tensorflow with the devtools-3 and with cuda

export JAVA_HOME=/software/jdk1.8.0_20

export PATH=/software/jdk1.8.0_20/bin:/opt/rh/devtoolset-3/root/usr/bin:/software/anaconda2/bin:/software/cuda-7.5.18/bin:$PATH

export LD_LIBRARY_PATH=/opt/rh/devtoolset-3/root/usr/lib64:/opt/rh/devtoolset-3/root/usr/lib:/software/cuda-7.5.18/lib64:/software/anaconda2/lib64:/software/anaconda2/lib:$LD_LIBRARY_PATH

We run configure in tensorflow to setup our cuda envirnment:

cd tensorflow

Fix the google/protobuf/BUILD file changing:

LINK_OPTS = [“-lpthread”]

to

LINK_OPTS = [“-lpthread”,”-lrt”,”-lm”]

and configure it

./configure

Please specify the location of python. [Default is /software/anaconda2/bin/python]:

Do you wish to build TensorFlow with GPU support? [y/N] y

GPU support will be enabled for TensorFlow

Please specify the Cuda SDK version you want to use, e.g. 7.0. [Leave empty to use system default]: 7.5

Please specify the location where CUDA 7.5 toolkit is installed. Refer to README.md for more details. [Default is /usr/local/cuda]: /software/cuda-7.5.18

Please specify the Cudnn version you want to use. [Leave empty to use system default]:

Please specify the location where cuDNN library is installed. Refer to README.md for more details. [Default is /software/cuda-7.5.18]:

Please specify a list of comma-separated Cuda compute capabilities you want to build with.

You can find the compute capability of your device at: https://developer.nvidia.com/cuda-gpus.

Please note that each additional compute capability significantly increases your build time and binary size.

[Default is: “3.5,5.2”]: 3.5

As we did in bazel, we need to fix the CROSSTOOL file third_party/gpus/crosstool/CROSSTOOL:

toolchain {

abi_version: “local”

abi_libc_version: “local”

builtin_sysroot: “”

compiler: “compiler”

host_system_name: “local”

needsPic: true

supports_gold_linker: false

supports_incremental_linker: false

supports_fission: false

supports_interface_shared_objects: false

supports_normalizing_ar: false

supports_start_end_lib: false

supports_thin_archives: false

target_libc: “local”

target_cpu: “local”

target_system_name: “local”

toolchain_identifier: “local_linux”tool_path { name: “ar” path: “/opt/rh/devtoolset-3/root/usr/bin/ar” }

tool_path { name: “compat-ld” path: “/opt/rh/devtoolset-3/root/usr/bin/ld” }

tool_path { name: “cpp” path: “/opt/rh/devtoolset-3/root/usr/bin/cpp” }

tool_path { name: “dwp” path: “/opt/rh/devtoolset-3/root/usr/bin/dwp” }

# As part of the TensorFlow release, we place some cuda-related compilation

# files in third_party/gpus/crosstool/clang/bin, and this relative

# path, combined with the rest of our Bazel configuration causes our

# compilation to use those files.

tool_path { name: “gcc” path: “clang/bin/crosstool_wrapper_driver_is_not_gcc” }

# Use “-std=c++11” for nvcc. For consistency, force both the host compiler

# and the device compiler to use “-std=c++11”.

cxx_flag: “-std=c++11”

linker_flag: “-lstdc++”

linker_flag: “-B/opt/rh/devtoolset-3/root/usr/bin/”# TODO(bazel-team): In theory, the path here ought to exactly match the path

# used by gcc. That works because bazel currently doesn’t track files at

# absolute locations and has no remote execution, yet. However, this will need

# to be fixed, maybe with auto-detection?

cxx_builtin_include_directory: “/opt/rh/devtoolset-3/root/usr/lib/gcc/”

cxx_builtin_include_directory: “/usr/local/include”

cxx_builtin_include_directory: “/usr/include”

cxx_builtin_include_directory: “/opt/rh/devtoolset-3/root/usr/include”

tool_path { name: “gcov” path: “/opt/rh/devtoolset-3/root/usr/bin/gcov” }# C(++) compiles invoke the compiler (as that is the one knowing where

# to find libraries), but we provide LD so other rules can invoke the linker.

tool_path { name: “ld” path: “/opt/rh/devtoolset-3/root/usr/bin/ld” }tool_path { name: “nm” path: “/opt/rh/devtoolset-3/root/usr/bin/nm” }

tool_path { name: “objcopy” path: “/opt/rh/devtoolset-3/root/usr/bin/objcopy” }

objcopy_embed_flag: “-I”

objcopy_embed_flag: “binary”

tool_path { name: “objdump” path: “/opt/rh/devtoolset-3/root/usr/bin/objdump” }

tool_path { name: “strip” path: “/opt/rh/devtoolset-3/root/usr/bin/strip” }# Anticipated future default.

unfiltered_cxx_flag: “-no-canonical-prefixes”# Make C++ compilation deterministic. Use linkstamping instead of these

# compiler symbols.

unfiltered_cxx_flag: “-Wno-builtin-macro-redefined”

unfiltered_cxx_flag: “-D__DATE__=\”redacted\””

unfiltered_cxx_flag: “-D__TIMESTAMP__=\”redacted\””

unfiltered_cxx_flag: “-D__TIME__=\”redacted\””# Security hardening on by default.

# Conservative choice; -D_FORTIFY_SOURCE=2 may be unsafe in some cases.

# We need to undef it before redefining it as some distributions now have

# it enabled by default.

compiler_flag: “-U_FORTIFY_SOURCE”

compiler_flag: “-D_FORTIFY_SOURCE=1”

compiler_flag: “-fstack-protector”

compiler_flag: “-fPIE”

linker_flag: “-pie”

linker_flag: “-Wl,-z,relro,-z,now”# Enable coloring even if there’s no attached terminal. Bazel removes the

# escape sequences if –nocolor is specified. This isn’t supported by gcc

# on Ubuntu 14.04.

# compiler_flag: “-fcolor-diagnostics”# All warnings are enabled. Maybe enable -Werror as well?

compiler_flag: “-Wall”

# Enable a few more warnings that aren’t part of -Wall.

compiler_flag: “-Wunused-but-set-parameter”

# But disable some that are problematic.

compiler_flag: “-Wno-free-nonheap-object” # has false positives# Keep stack frames for debugging, even in opt mode.

compiler_flag: “-fno-omit-frame-pointer”# Anticipated future default.

linker_flag: “-no-canonical-prefixes”

unfiltered_cxx_flag: “-fno-canonical-system-headers”

# Have gcc return the exit code from ld.

linker_flag: “-pass-exit-codes”

# Stamp the binary with a unique identifier.

linker_flag: “-Wl,–build-id=md5”

linker_flag: “-Wl,–hash-style=gnu”

# Gold linker only? Can we enable this by default?

# linker_flag: “-Wl,–warn-execstack”

# linker_flag: “-Wl,–detect-odr-violations”compilation_mode_flags {

mode: DBG

# Enable debug symbols.

compiler_flag: “-g”

}

Similarly, we also need to fix /third_party/gpus/crosstool/clang/bin/crosstool_wrapper_driver_is_not_gcc to choose the devtools-3 tools.

Now, we will build a build_pip_package:

bazel build -c opt –config=cuda –genrule_strategy=standalone –verbose_failures //tensorflow/tools/pip_package:build_pip_package

I got an error, "ImportError: No module named argparse" so I had to change also the first line of /third_party/gpus/crosstool/clang/bin/crosstool_wrapper_driver_is_not_gcc to:

#!/usr/bin/env /software/anaconda2/bin/python2

Then, we create the python wheel package:

tensorflow/tools/pip_package/build_pip_package /tmp/tensorflow_pkg

In my case, I had to run

/root/.cache/bazel/_bazel_root/28150a65056607dabfb056aa305868ed/tensorflow/bazel-out/local_linux-opt/bin/tensorflow/tools/pip_package/build_pip_package /tmp/tensorflow_pkg

And finally we can install it using pip:

bazel build -c opt –config=cuda –genrule_strategy=standalone //tensorflow/cc:tutorials_example_trainer

pip install /tmp/tensorflow_pkg/tensorflow-0.7.1-py2-none-any.whl

We also tried to compile the tutorials_example_trainer as shown in the tensorflow webpage:

bazel build -c opt –config=cuda –genrule_strategy=standalone //tensorflow/cc:tutorials_example_trainer

And successfully run the test:

tutorials_example_trainer –use_gpu

We would like to thank Kike from IXA-taldea for sharing with us his guide to compile tensorflow in CPUs.

EHUbox, el almacenamiento en la nube de la UPV/EHU

La UPV/EHU ha creado el servicio de almacenamiento EHUbox. Para describir rápidamente este servicio podemos decir que es similar al conocido Dropbox con la diferencia fundamental de que los datos son guardados en servidores propios de la UPV/EHU, por lo que cumple con mayores requerimientos de seguridad y privacidad de la LOPD al no enviarse los datos a servidores externos.

La UPV/EHU ha creado el servicio de almacenamiento EHUbox. Para describir rápidamente este servicio podemos decir que es similar al conocido Dropbox con la diferencia fundamental de que los datos son guardados en servidores propios de la UPV/EHU, por lo que cumple con mayores requerimientos de seguridad y privacidad de la LOPD al no enviarse los datos a servidores externos.

Características y funcionalidades

El servicio que ha puesto en marcha la Vicegerencia de las TICs tiene las siguientes características principales:

- No hay que solicitarlo. El personal de la UPV/EHU lo tiene asignado y basta con conectarse a la página web http://ehubox.ehu.es para acceder al almacenamiento personal.

- Se ha asignado una cuota personal de 50 GB.

- Métodos de acceso al almacenamiento.

- Con un navegador a través de la url anterior y trabajando desde la web.

- También se puede acceder desde móviles mediante apps tanto para Android como para Iphone. La app oficial de Owncloud tiene un coste de 0.73 € mientras que la de oCloud es gratuíta. También son gratuítas las que encontramos en F-Droid. Conectarse a la dirección ehubox.ehu.es desde la app para acceder.

- Se puede instalar el cliente para PC (Windows, Linux o Mac) y se accede a al servicio como si fuese una carpeta normal (descarga de clientes). Conectarse a la dirección ehubox.ehu.es en el cliente apara acceder.

- Mediante el protocolo webdav, para entenderlo mejor podemos decir que es similar al protocolo ftp. Por ejemplo desde un navegador de archivos con la siguiente ruta o conexión a servidor davs://ehubox.ehu.eus/owncloud/remote.php/webdav.

- La aplicación permite compartir archivos fácilmente. Para ello hay dos mecanismos.

- Con otro personal de la UPV/EHU mediante su usuario de LDAP para compartir una carpeta o fichero internamente. Una vez compartida la carpeta aparece inmediatamente en el area de quien con hayamos compartido.

- La segunda opción es generando un enlace web aleatorio que permite compartir los ficheros o carpetas. Enviando este enlace a otra persona esta puede descargarse el fichero tanto desde dentro como desde fuera de la UPV/EHU.

- Los datos pueden compartirse con el exterior mediante enlace, pero estos están almacenados en discos en la propia UPV/EHU no en servidores externos a la UPV/EHU hasta que se descargan.

- Se pueden crear grupos de trabajo y compartir ficheros y carpetas con el grupo (solicitar la creación del grupo al CAU).

- Permite trabajo edición y trabajo colaborativo con documentos .odt, .docx y .doc.

- Papelera para recuperar archivos borrados en lo últimos 30 días.

- La infraestructura física que existe por debajo es la misma que la de EHUstorage, el sistema de almacenamiento masivo para personal de la UPV/EHU que ya describimos en este post. Por lo que es un sistema altamente seguro ante fallos del hardware.

Nota

El sistema está completamente operativo y es estable, pero aún continua en fase de pruebas.

Más información

ehuSTORAGE: Sistema de almacenamiento masivo de la UPV/EHU para el personal.

http://www.ehu.eus/es/group/ikt-tic/ehubox

2014 a positive year for the IZO-SGI Computing Service

2014 year report

The Computing Service IZO-SGI SGIker of the UPV/EHU has published the 2014 year report, which can be found in the next link:

IZO-SGI 2014 year report (pdf in spanish)

The Computing Service has maintained or increased its main quality indicators as can be observed in the table below. Among the positive aspects, the increase in the use of the resources and the increase of the HPC resources that where available at the end of the year. In the negative part, we can mention the reduction of the scientific publications . The Service continues having an excellent score in the satisfaction poll between the researches.

Acknowledgments

We would like to acknowledgment to all the researchers that have relied on the service, most of the good results of the Service are in fact their merits and not ours.

2014 Relevant posts in our Blog

The IZO-SGI in numbers

In the table below, the main figures of the Service in the last years is summarized and in the graph at the very bottom the use of Arina is shown.

| 2009 | 2010 | 2011 | 2012 | 2013 | 2014 | |

| Computing cores | 440 | 872 | 1.520 | 1.520 | 1.400 | 1.3008 |

| Consumed millions of hours | 2,11 | 2,26 | 5,76 | 11,27 | 10,4 | 10,1 |

| Active researches | 101 | 98 | 90 | 89 | 99 | 107 |

| Active groups | 53 | 40 | 39 | 42 | 47 | 45 |

| New accounts | 49 | 33 | 33 | 20 | 34 | 23 |

| Satisfaction of the researches¹ | 8.9 | 8.8 | 8.8 | 9,3 | 9,3 | 9,6 |

| Scientific articles² | 44 | 58 | 57 | 74 | 87 | 75 |

| Web visits | 4.925 | 5.957 | 8.022 | 9.899 | 5.924 | 2.340 |

| View pages | 58.731 | 40.987 | 30.042 | 30.738 | 20.323 | 12.057 |

| Posts in the HPC blog | – | 29 | 34 | 27 | 47 | 36 |

| Visits of the HPC blog | – | 1.431 | 3.818 | 4.741 | 24.613 | 23.677 |

| Arina | ||||||

| Computing cores | 320 | 752 | 1.360 | 1.360 | 1.320 | 1.300 |

| Consumed millions of hours | 2,07 | 2,11 | 5,20 | 9,6 | 9,8 | 10,1 |

| Mean occupation | 75% | 47%³ | 74% | 79% | 83% | 87% |

| Submitted jobs | 38.497 | 65.179 | 68.991 | 98.383 | 100.214 | 76.912 |

| More than 2 minutes jobs⁴ | 28.377 | 50.624 | 51.735 | 78.846 | 75.406 | 64.335 |

| Job mean computing time⁵ | 76 hours | 44 hours | 101 hours | 122 hours | 130 hours | 156 hours |

| Job mean waiting time⁶ | 5,7 hours | 3,8 hours | 3,8 hours | 5,2 hours | 5,5 hours | 10 hours |

| Péndulo | ||||||

| Computing cores | 120 | 120 | 120 | 80 | 80 | 70 |

| Consumed millions of hours | 0,02 | 0,15 | 0,09 | 0,07 | 0,04 | 0,006 |

| Ikerbasque | ||||||

| Computing cores | – | – | 208 | 208 | 208 | – |

| Consumed millions of hours | – | – | 0,47 | 1,6 | 0,55 | – |

¹ Satisfaction pool by the SGIker Quality Unit.

² Where the IZO-SGI is acknowledged.

³ The use in 2010 is apparently low because new machines where installed passing form 300 cores to 752 cores in July. In August and September Arina was quite empty and the weigh of these months has had a lot of importance in the mean value. In fact in November the mean use was already in the 76%.

⁴ Jobs with less than 2 minutes of computing time are usually failed jobs. In any case due to the short duration they don’t have relevance in the usage.

⁵ The jobs with less than 2 minutes of computing time are not taken into account.

⁶ The jobs are executed through a queue system that assign proper resources to the jobs. The waiting time is the time the jobs spend in the queue waiting for the resources to be available.

⁷ The machine was switch off in April.

8 At the end of the year we got 652 new cores.

Balance positivo para el Servicio de Computación IZO-SGI

Memoria 2014

El Servicio de Informática Aplicada a la Investigación (Cálculo Científico) IZO-SGI SGIker ha publicado la memoria del 2014. La memoria completa puede encontrarse en el siguiente enlace:

IZO-SGI memoria del 2014 (pdf)

El 2014 el Servicio General de Informática Aplicada a la Investigación (Cálculo Científico) de la UPV/EHU ha seguido su tendencia mejorando o manteniendo la mayoría de sus índice, que se resumen en la tabla inferior. Entre los aspectos negativos, la disminución de las publicaciones, y entre los positivos el incremento significativo de ocupación de la máquina sin excesivo impacto en los tiempos de espera y la ampliación que se puso operativa a finales de año. El Servicio sigue manteniendo una excelente puntuación en la encuesta de satisfacción de los investigadores.

Agradecimientos

Queremos aprovechar estas líneas para agradecer la confianza depositada en el Servicio por los investigadores dado que buena parte de los buenos números del Servicio son más mérito suyo que nuestro.

Posts relevantes del 2014 en el Blog del IZO-SGI SGIker

El IZO-SGI en cifras

En la siguiente tabla se resumen los datos más significativos del Servicio de cálculo en los últimos años. En la figura inferior se muestra la ocupación de Arina.

| 2009 | 2010 | 2011 | 2012 | 2013 | 2014 | |

| Cores de cálculo | 440 | 872 | 1.520 | 1.520 | 1.400 | 1.3008 |

| Millones de horas de cálculo consumidas | 2,11 | 2,26 | 5,76 | 11,27 | 10,4 | 10,1 |

| Investigadores activos | 101 | 98 | 90 | 89 | 99 | 107 |

| Grupos activos | 53 | 40 | 39 | 42 | 47 | 45 |

| Cuentas nuevas | 49 | 33 | 33 | 20 | 34 | 23 |

| Satisfacción de los investigadores¹ | 8.9 | 8.8 | 8.8 | 9,3 | 9,3 | 9,6 |

| Artículos científicos² | 44 | 58 | 57 | 74 | 87 | 75 |

| Visitas web | 4.925 | 5.957 | 8.022 | 9.899 | 5.924 | 2.340 |

| Páginas vistas | 58.731 | 40.987 | 30.042 | 30.738 | 20.323 | 12.057 |

| Posts en el blog HPC | – | 29 | 34 | 27 | 47 | 36 |

| Visitas del blog HPC | – | 1.431 | 3.818 | 4.741 | 24.613 | 23.677 |

| Arina | ||||||

| Cores de cálculo | 320 | 752 | 1.360 | 1.360 | 1.320 | 1.300 |

| Millones de horas de cálculo consumidas | 2,07 | 2,11 | 5,20 | 9,6 | 9,8 | 10.1 |

| Promedio de ocupación | 75% | 47%³ | 74% | 79% | 83% | 87% |

| Trabajos enviados | 38.497 | 65.179 | 68.991 | 98.383 | 100.214 | 76.912 |

| Trabajos de más de 2 minutos⁴ | 28.377 | 50.624 | 51.735 | 78.846 | 75.406 | 64.335 |

| Tiempo promedio por trabajo⁵ | 76 horas | 44 horas | 101 horas | 122 horas | 130 horas | 156 horas |

| Tiempo medio de espera⁶ | 5,7 horas | 3,8 horas | 3,8 horas | 5,2 horas | 5,5 horas | 10 horas |

| Péndulo | ||||||

| Cores de cálculo | 120 | 120 | 120 | 80 | 80 | 70 |

| Millones de horas de cálculo consumidas | 0,02 | 0,15 | 0,09 | 0,07 | 0,04 | 0,006 |

| Recursos Ikerbasque | ||||||

| Cores de cálculo | – | – | 208 | 208 | 208 | – |

| Millones de horas de cálculo consumidas | – | – | 0,47 | 1,6 | 0,55 | – |

¹ Encuesta de satisfacción de los usuarios del Servicio realizada por la Unidad de Calidad de SGIker. ² En los que se agradece al IZO-SGI. ³ El uso de 2010 es aparentemente bajo debido a que se instaló una ampliación de Arina que pasó de 300 cores a 752 y se hizo disponible a finales de Julio. Esto provocó que en Agosto y Septiembre Arina estuviese muy vacía y, debido a la magnitud de la ampliación, estos meses han tenido mucho peso en la media anual. En el mes de Noviembre ya se alcanzó un 76% de ocupación. ⁴ Los trabajos de menos de 2 minutos se deben normalmente a trabajos fallidos que terminan inmediatamente en error. En cualquier caso, aun de no ser así, dada su corta duración no repercuten en el cluster. ⁵ No se han tenido en cuenta los trabajos de menos de dos minutos. ⁶ Los trabajos se ejecutan a través de un sistema de colas que asigna a cada trabajo los recursos que se le han solicitado y ordena su ejecución para optimizar el uso del cluster. El tiempo en cola es el tiempo que están esperando los trabajos hasta que se liberan los recursos que necesitan. ⁷ La máquina se apagó en Abril.8A finales de 2014 con la ampliación se llegó a los 1850 cores.

2014 urtea ere urte positiboa IZO-SGI Konputazio Zerbitzuarentzat

2014 Memoria

Ikerkuntzari zuzendutatko Informatikako zerbitzuak (Kalkulu Zientifikoa) IZO-SGI SGIker 2014ko txostena argitaratu du. Txosten osoa ondorengo estekan dago:

2014ko IZO-SGIren urteko txostena (pdf gazteleraz)

UPV/EHUko Kalkulu Zerbitzuak balantze positiboa izan du 2014. urtean. Bere zenbaki ia gehienak hobetu edo mantendu ditu beheko taulan ikusi daiteken moduan. Atal positiboen artean, makinaren erabilpenaren igoera eta urte bukaeran egindako baliabideen handitzea, nabarmendu ditzakegu. Elementu negatiboen aldetik, publikazio kopuruaren jeitxiera ikusten dugu. Zerbitzuak, bestalde, erabiltzaileen artean egindako inekestan oso puntuazio ona jaso du berriz ere.

Eskeronak

Zerbitzuko memoriarekin batera, zerbitzuko ikertzaileak eskertzen ditugu Zerbitzuan jarritako konfiantzagatik, izan ere, Zerbitzuaren zenbaki onak beraien merituak baitira.

2014. urtean zehar blogean publikatutako post nabarmenenak.

IZO-SGI zerbitzua zenbakietan

Ondorengo taulan azken urteko Zerbitzuko datu esanguratsuenak laburbiltzen dira. Beheko irudian berriz Arinaren erabilera erakusten da.

| 2009 | 2010 | 2011 | 2012 | 2013 | 2014 | |

| Kalkulu koreak | 440 | 872 | 1.520 | 1.520 | 1.400 | 1.3008 |

| Erabilitako kalkulu orduak (milioiak) | 2,11 | 2,26 | 5,76 | 11,27 | 10,4 | 10,1 |

| Ikertzaile aktiboak | 101 | 98 | 90 | 89 | 99 | 107 |

| Talde aktiboak | 53 | 40 | 39 | 42 | 47 | 45 |

| Kontu berriak | 49 | 33 | 33 | 20 | 34 | 23 |

| Ikertzaileen satisfakzioa¹ | 8.9 | 8.8 | 8.8 | 9,3 | 9,3 | 9,6 |

| Artikulu zientifikoak² | 44 | 58 | 57 | 74 | 87 | 75 |

| Web bisitak | 4.925 | 5.957 | 8.022 | 9.899 | 5.924 | 2.340 |

| Orrialde ikusiak | 58.731 | 40.987 | 30.042 | 30.738 | 20.323 | 12.057 |

| Postak HPC blogan | – | 29 | 34 | 27 | 47 | 36 |

| Bisitak HPC blogan | – | 1.431 | 3.818 | 4.741 | 24.613 | 23.677 |

| Arina | ||||||

| Kalkulu koreak | 320 | 752 | 1.360 | 1.360 | 1.320 | 1.300 |

| Erabilitako kalkulu orduak (milioiak) | 2,07 | 2,11 | 5,20 | 9,6 | 9,8 | 10,1 |

| Okupazio batez bestekoa | 75% | 47%³ | 74% | 79% | 83% | 87% |

| Bidalitako lanak | 38.497 | 65.179 | 68.991 | 98.383 | 100.214 | 76.912 |

| 2 minutuko baino gehiagoko lanak⁴ | 28.377 | 50.624 | 51.735 | 78.846 | 75.406 | 64.335 |

| Batez besteko lanen denbora⁵ | 76 | 44 | 101 | 122 | 130 | 156 |

| Batez besteko itxaron denbora⁶ | 5,7 | 3,8 | 3,8 | 5,2 | 5,5 | 10 |

| Péndulo | ||||||

| Kalkulu koreak | 120 | 120 | 120 | 80 | 80 | 70 |

| Erabilitako kalkulu orduak (milioiak) | 0,02 | 0,15 | 0,09 | 0,07 | 0,04 | 0,006 |

| Ikerbasque | ||||||

| Kalkulu koreak | – | – | 208 | 208 | 208 | – |

| Erabilitako kalkulu orduak (milioiak) | – | – | 0,47 | 1,6 | 0,55 | – |

¹ SGIker Kalitate unitateagatik egindako zerbitzuari buruzko inkesta.

² Non IZO-SGI eskertzen da.

³ 2010ko erabilera nahiko txikia diruri, makina berriak instalatu ziren 300 koretik 752ra pasatzen eta Uztailaren bukaeran izan zen. Abuztuan eta Irailan makina oso utxik egon zen eta hilabete hauek pisu handia eduki dute urteko batazbestekoan. Azaroan adibidez erabilpena %76 zen berriz.

⁴ 2 minutu baino gutxiago irauten duten lanak normalean kale egin duten lanak dira. Bere iraupen motxagatik pisu txikia dute clusterraren erabileran.

⁵ Unitatea ordutan. Ez dira kontutan hartu bi minutu baino gutxiagoko lanak.

⁶ Unitatea ordutan. Lanek kola sistema baten bitartez bideratzen dira zeinek lan bakoitzari dagokion baliabideak ematen dizkio. Lanen itxaron denbora kolan baliabideak itxoiten ematen duten denbora da.

⁷ Makina apirilean itzali zen.

8 Urte bukaeran 652 kore berri gehitu genituen.

Resumen de Posts del 2014 / 2014 Posten Laburpena

Aurten blogean argitaraturiko post aipagarrienak.

Post más relevantes publicados este año en el blog.

¿Podemos apoyar tus solicitudes para a lograr financiación para tu investigación?

En el Servicio de Cálculo Científico de la UPV/EHU (IZO-SGI) creemos que podemos ser un firme apoyo para tus solicitudes de fondos en proyectos de investigación que involucren computación científica dada la calidad y reputación del Servicio. La política europea en materia de computación impulsa el acceso a recursos de computación abiertos y compartidos como los del IZO-SGI, en contraposición a recursos monopolizados por usuarios individuales.

Desde este punto de vista hemos redactado en detalle datos técnicos y de gestión de nuestro Servicio que podrían ser interesantes para incluir en una solicitud de fondos para acceso a infraestructura de computación. Para cualquier pregunta, solicitud o aclaración no dudes en ponerte en contacto con nosotros.

No tengas reparos en copiar, resumir o adaptar este texto a tus solicitudes.

Introducción

El Servicio General de Informática Aplicada a la investigación (Cálculo Científico), en adelante IZO-SGI, está adscrito en los Servicios Generales de Investigación (SGIker) de la UPV/EHU. El Servicio de Cálculo IZO-SGI ofrece acceso a recursos computacionales de altas prestaciones, software y soporte de calado y entidad. Presta servicio a toda la comunidad científica, en particular a los investigadores de la UPV/EHU (principal institución de investigación en Euskadi), pero además está accesible a toda la comunidad científica y empresarial. El IZO-SGI dispone desde 2004 de un cluster de computación completo que ha ido ampliando regularmente para satisfacer la creciente demanda de un amplio espectro de grupos de investigación que abarcan todas las áreas de la Ciencia (Física, Química, Ingeniería, Informática, Matemáticas, Biología, Geología, Economía, etc).

Infraestructura

Un cluster de cálculo de altas prestaciones no es equipamiento informático al uso, es equipamiento científico complejo que requiere personal cualificado y específico para su gestión, además de estar ubucado en un lugar que grantice su óptimo funcionamiento y rendimiento.

El cluster ha sido diseñado por los miembros del Servicio de Cálculo IZO-SGI como una única infraestructura totalmente integrada, pero cuya heterogeneidad lo convierte en una herramienta válida para satisfacer las necesidades de un amplio espectro de investigaciones en cualquiera de las áreas de la Ciencia, como lo demuestra las investigaciones en las que se emplea. En concreto se dispone de:

- Política de ampliación y renovación bienal.

- 3.728 cores de cálculo en nodos 212 nodos, 10 de arquitectura IA64 y 202 x86-64 que permiten la ejecución de cálculos estándar y de uso masivo de cpu.

- 6 nodos con 2 GPGPUs Nvidia Tesla por nodo para extraer el máximo rendimiento a programas que explotan de forma muy eficiente esta nueva tecnología.

- Nodos con gran memoria RAM para trabajos con estos requerimientos, hasta un máximo de 512 GB de RAM por nodo.

- Sistemas de ficheros de alto rendimiento con gran capacidad y velocidad de lectura/escritura basados en Lustre. 3 sistemas diferentes con hasta 40 TB y hasta 7 GB/s de velocidad en lectura y escritura.

- Todo interconectado por una red de alto ancho de banda y baja latencia infiniband, la última ampliación infiniband FDR de 56 Gb/s de ancho de banda.

- Servidores de gestión en alta disponibilidad para garantizar una operación 24h*365 días.

- Todo instalado en el Centro de Proceso de Datos (CPD) de la UPV/EHU con toda una variedad de sistemas para garantizar un funcionamiento óptimo (ver siguiente punto para los detalles del CPD).

Para ver detalles técnicos más concretos visitar el apartado de recursos computacionales de la página web del IZO-SGI.

Además, la concentración de recursos materiales y humanos en el Servicio de Cálculo IZO-SGI ha creado un comunidad y permite acceder a los grupos a recursos cualitativa y cuantitativamente superiores en todos los sentidos con la consiguiente mejora de los resultados. El aprovechamiento y amortización de la infraestructura y costes secundarios asociados a la misma es extremadamente eficiente y eficaz.

Ubicación, CPD o centro de datos

El equipamiento se instala en el Centro de Proceso de Datos (CPD) de la UPV/EHU. El CPD de 450 m² y de nueva construcción, en 2006, es un lugar habilitado para la ubicación de computadores y está capacitado con todos los sistemas necesarios para garantizar el correcto funcionamiento de ellos. Dispone de:

- Sistemas de climatización de precisión por expansión directa exclusivo y sistema de descalcificación del agua. Los 7 aparatos de aire acondicionado con una potencia agregada de 208KW, lo que asegura una redundancia N+1 ante posibles fallos.

- Sistema contraincendios. Sistema de detección de incendios mediante detectores ópticos y térmicos. Sistema de extinción por agua nebulizada HI-FOG, que preserva la integridad del equipamiento informático en caso de activación.

- Acometida desde dos transformadores independientes.

- Doble rama eléctrica para los equipos IT, cada una con SAIs (sistemas de alimentación ininterrumpida) independiente y cuadros de baja tensión independientes. Permite redundancia y mantenimiento en caliente de la instalación eléctrica.

- Grupo electrógeno de 750 KVA con dos días de autonomía sin necesidad de repostar.

- Control de acceso, alarmas y vigilancia mediante circuito cerrado de TV.

- Copias de seguridad de datos y sistemas de las máquinas.

- Monitorización por parte de operadores in-situ y sistema de gestión y control de las instalaciones.

- Metodología 5S para la mejora de la calidad.

Los equipamientos están monitorizados in-situ e informáticamente y tiene los mantenimientos y en regla con revisiones periódicas incluídas.

La Vicegerencia de las TICs dispone en otro edificio incluso de un CPD secundario de respaldo del primer CPD donde mantiene duplicados los servicios básicos para en caso de grave desastre poder mantener la operativa. Por ejemplo, las copias de seguridad se realizan en este CPD secundario para mantener separados los datos y sus copias de seguridad.

Esta moderna infraestructura permite un funcionamiento ininterrumpido 24h*7 días de las máquinas tremendamente estable.

Otros servicios

La Vicegerencia de las TICs mantiene la red de datos de la UPV/EHU que está formada por tecnologías de primera línea y de última generación. Esto permite que se puedan establecer conexiones con gran ancho de banda (hasta 10Gbps) y un alto grado de seguridad, algo fundamental para trabajar con eficacia en una infraestructura a la que hay que conectarse remotamente. La red dispone de elementos hardware redundantes y líneas de comunicación duplicadas con caminos diversificados, así como firewall perimetral, zonas de red desmilitarizadas, balanceadoras, sistemas hardware de detección de orígenes inseguros o potencialmente peligrosos, etc. La conexión con Internet, hacia el exterior, se realiza a través de i2Basque, la red de datos autonómica, que a su vez conecta con RedIRIS, la red académica y de investigación Española.

Dentro de los servicios de investigación que ofrece la Vicegerencia de las TICs cabe destacar por su relevancia para la computación de altas prestaciones la de un sistema de almacenamiento masivo para investigadores integrable en el Servicio. Este es altamente seguro al existir, entre otras medidas, una copia de respaldo en el CPD secundario y es escalable en capacidad y ancho de banda para satisfacer las necesidades actuales y futuras.

Personal

Personal técnico específico

Un cluster de cálculo de HPC no es equipamiento científico normal sino equipamiento científico puntero y complejo. El diseño y gestión específica y particular que requiere el entorno de cálculo está gestionado por dos doctores en Química y Física con amplia experiencia en HPC, dos de las áreas científicas que más uso hacen de la computación de altas prestaciones, lo que les permite ofrecer un servicio de asesoramiento científico de alto valor añadido. Llevan al frente del Servicio desde 2004 y ya tenían experiencia previa en gestión de entornos HPC y durante sus respectivas tesis doctorales hicieron uso de cálculo intensivo.

Además, se cuenta con el soporte técnico de la Vicegerencia de las TICs, el técnico-administrativo de los SGIker y el general de la UPV/EHU. Hau ez da infraestructura.

La estructura administrativa del SGIker de la UPV/EHU, 12 personas, se encarga de las tareas administrativas como gestión económica, dirección y administración general. Los SGIker disponen de unidades que también dan apoyo interno como son el Servicio de Calidad e Innovación, el de Cienciometría y el de infraestructura.

Personal técnico no específico

Un director científico con amplia experiencia, conocimientos y visión de la computación de altas prestaciones en general y en el campo de la química computacional en particular guía al servicio en la toma de decisiones estratégicas.

La Vicegerencia de las Tecnologías de la Información y la Comunicación es el mayor departamento de la UPV/EHU por personal. El personal dedicado a tareas informáticas supera con creces las 150 personas. El IZO-SGI mantiene un estrecho contacto y colaboración con diversas áreas de la Vicegerencia de las TICs:

- Con el área de explotación que se encarga del mantenimiento de servicios, equipamiento, monitorización, etc de los que hace uso el IZO-SGI.

- Con el área de redes para habilitar los servicios de red, puertos, reglas, etc que se requieren para el correcto funcionamiento de hardware y software del IZO-SGI y la conexión remota de los investigadores a nuestros clusters.

- Con el área aulas docentes que nos apoya en la gestión del GRID Péndulo que usa las aulas docentes por la noche para cálculo científico. También para la instalación de software que gestiona el IZO-SGI que se usa para docencia además de para investigación.

- Con el área de atención al usuario, que resuelve problemas a los investigadores en su puesto local que por su tipología puede ser resuelto más eficazmente por un técnico informático in-situ, como por ejemplo la instalación de software en sus equipos personales.

Al estar integrados en la UPV/EHU disponemos de todos los servicios que esta ofrece con el personal asociado a la misma y perteneciente a la propia estructura administrativa y técnica de la UPV/EHU.

Póliticas de calidad y evaluación

Los SGIker, están volcados con la calidad y tienen definida la política de calidad que sirve de marco de referencia en el establecimiento de los objetivos, metas y programas de calidad implantados. La calidad de los servicios ofrecidos es la piedra angular de la competencia investigadora y productiva, y por lo tanto, de los SGIker. Prueba de este compromiso es la existencia de la Unidad de Calidad e Innovación que centra sus esfuerzos en la implantación, mantenimiento y mejora continua de un Sistema de Gestión de la Calidad basado en Normas Internacionales y con reflejo en la plataforma documental del sistema de gestión de calidad.

La Unidad de Calidad e Innovación de los SGIker realiza todos los años de forma independiente y entre los investigadores usuarios una encuesta de satisfacción del IZO-SGI. El IZO-SGI ha obtenido en 2014 una valoración de 9.6 y tiene una media en los últimos 5 años de 9.1.

Comentarios