¿Qué es LabVIEW?

LabVIEW es el acrónimo de Laboratory Virtual Instrument Engineering Workbech. Es un lenguaje y, a la vez, una plataforma y entorno de desarrollo para diseñar sistemas, con un lenguaje de programación visual gráfico pensado para sistemas hardware y software de pruebas, control y diseño, simulado o real y embebido.

Se trata de un entorno de desarrollo diseñado específicamente para acelerar la productividad de ingenieros y científicos. El lenguaje utilizado para programar en él se llama Lenguaje G, donde la G simboliza que es un lenguaje de tipo gráfico. Este lenguaje de programación gráfica facilita la recopilación de datos de instrumentos de laboratorio utilizando sistemas de adquisición de datos. Además, se puede utilizar para las siguientes aplicaciones:

- Adquirir datos de instrumentos.

- Datos de procesos.

- Instrumentos y equipos de control.

Su sintaxis de programación gráfica ayuda a facilitar, visualizar, crear y codificar sistemas de ingeniería.

LabVIEW permite traer información del mundo exterior, gracias al módulo de tiempo real, a un ordenador.

Fue creado por National Instruments en 1976 para funcionar sobre máquinas MAC aunque actualmente está disponible para cualquier sistema operativo.

Pero ¿qué significa tiempo real?

El módulo LabVIEW Real-Time combina la programación gráfica de LabVIEW con la potencia de un sistema operativo en tiempo real, permitiéndole crear aplicaciones determinísticas en tiempo real.

Una idea equivocada sobre el tiempo real es que significa rápido. Más exactamente, tiempo real significa tiempo. En otras palabras, la respuesta en tiempo real es la capacidad, con fiabilidad y sin error, de responder a un evento o realizar una operación en un tiempo bien definido.

Con los sistemas operativos de propósito general, no se puede garantizar que la respuesta se produzca dentro de un período de tiempo determinado, y los cálculos pueden finalizar mucho más tarde o antes de lo esperado.

Para que un sistema sea un sistema en tiempo real, todas sus partes deben ser en tiempo real. Así, aunque un programa se ejecute en un sistema operativo en tiempo real, esto no significa que el programa se comporte con características en tiempo real. El programa puede depender de algo que no se comporta en tiempo real, lo que hace que el programa no se comporte en tiempo real.

Este concepto nos lleva a una siguiente pregunta,¿Que es el determinismo?

El determinismo es una característica de un sistema que describe la fiabilidad con la que puede responder a eventos externos o realizar operaciones dentro de un límite de tiempo determinado. El alto determinismo es una característica de los sistemas en tiempo real y garantiza que sus cálculos y operaciones se realicen en un tiempo determinado. Los sistemas deterministas son predecibles. Esta es una característica importante para aplicaciones como los controles. En una aplicación de control, el programa de control mide las entradas, realiza cálculos basados en las entradas y, a continuación, emite valores que son el resultado de dichos cálculos. Los sistemas en tiempo real pueden garantizar que los cálculos terminen a tiempo, todo el tiempo.

¿Y myRIO?

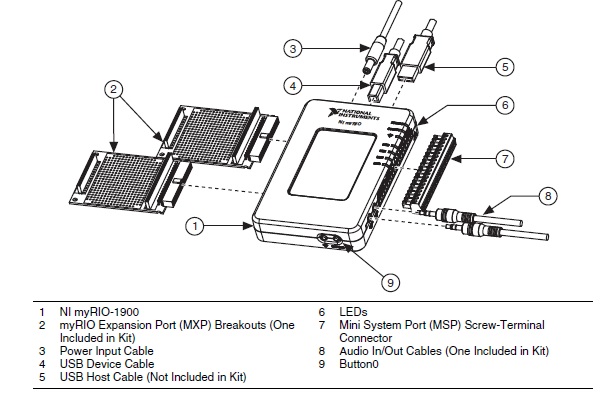

NI myRIO es un dispositivo portable hardware embebido desarrollado por National Instruments y programable por la herramienta software LabVIEW. Se puede utilizar para diseñar sistemas de control, robótica y mecatrónica. También incluye una antena WI-FI integrada que permite al usuario transferir datos inalámbricamente y desplegar código.

El procesador puede ser programado bien por C++, o bien en LabVIEW. En cambio la FPGA solo puede ser programada por el entorno de LabVIEW.

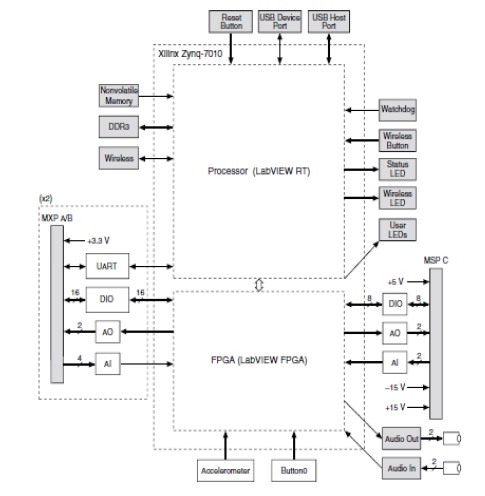

En esta imagen se puede observar el diagrama de bloques del hardware de myRIO: